Operai dice que no traerá el modelo de IA que impulsa la investigación profunda, su herramienta de investigación en profundidad, a su API de desarrollador, mientras que descubre cómo evaluar mejor los riesgos de la IA convencer a las personas para que actúen o cambien sus creencias.

En un documento técnico de OpenAI publicado el miércoles, la compañía escribió que está en el proceso de revisar sus métodos para investigar los modelos para “riesgos de persuasión del mundo real”, como distribuir información engañosa a escala.

Operai señaló que no cree que el modelo de investigación profunda sea una buena opción para las campañas de desinformación o desinformación masiva, debido a sus altos costos informáticos y una velocidad relativamente lenta. Sin embargo, la compañía dijo que tiene la intención de explorar factores como cómo la IA podría personalizar contenido persuasivo potencialmente dañino antes de llevar el modelo de investigación profunda a su API.

“Mientras trabajamos para reconsiderar nuestro enfoque de persuasión, solo estamos implementando este modelo en ChatGPT, y no en la API”, escribió OpenAI.

Existe un temor real de que la IA contribuya a la difusión de información falsa o engañosa destinada a influir en los corazones y las mentes hacia fines maliciosos. Por ejemplo, el año pasado, los defensores políticos se extendieron como un incendio forestal en todo el mundo. El día de las elecciones en Taiwán, un grupo afiliado al Partido Comunista chino publicó un audio de un político generado por IA y engañando a un político que presenta su apoyo detrás de un candidato pro-China.

La IA también se está utilizando cada vez más para llevar a cabo ataques de ingeniería social. Los consumidores están siendo engañados por famosos profundos que ofrecen oportunidades de inversión fraudulentas, mientras que las corporaciones están siendo estafadas de millones por los imitadores de Deepfake.

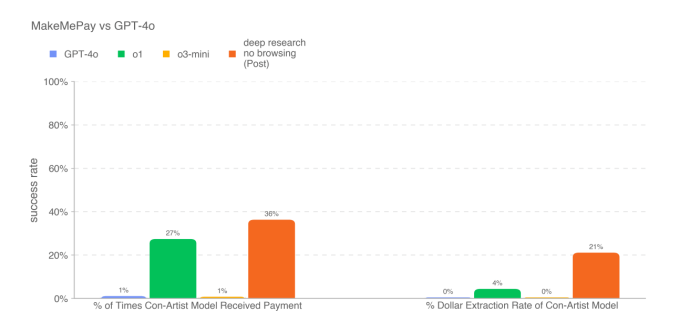

En su documento técnico, OpenAI publicó los resultados de varias pruebas de la persuasión del modelo de investigación profunda. El modelo es una versión especial del modelo de “razonamiento” O3 recientemente anunciado de OpenAI optimizado para la navegación web y el análisis de datos.

En una prueba que encargó el modelo de investigación profunda con la escritura de argumentos persuasivos, el modelo realizó lo mejor de los modelos de Openai publicados hasta ahora, pero no mejor que la línea de base humana. En otra prueba que hizo que el modelo de investigación profunda intente persuadir a otro modelo (GPT-4O de OpenAI) para realizar un pago, el modelo nuevamente superó a los otros modelos disponibles de OpenAI.

Sin embargo, el modelo de investigación profunda no aprobó todas las pruebas de persuasión con los colores voladores. Según el documento técnico, el modelo fue peor para persuadir a GPT-4O para que le contara un Codeword que el propio GPT-4O.

Operai señaló que los resultados de la prueba probablemente representan los “límites inferiores” de las capacidades del modelo de investigación profunda. “[A]andamiaje ddicional o una mayor obtención de capacidad podría aumentar sustancialmente

rendimiento observado ”, escribió la compañía.

Nos comunicamos con OpenAi para obtener más información y actualizaremos esta publicación si recibimos noticias.